はじめに

この記事で理解できること

・学習によってモデルをフィッティングさせる概念を理解できる。

・機械学習で回帰問題を解決する際に、未学習や過学習を評価できる。

・特に,

正則化などが及ぼす影響を理解できる。

バイアス-バリアンス分解とは

実データを用いてモデルをフィッティングした場合には、真のモデルとの間に「バイアス、バリアンス、ノイズ」の3つの要素によってズレが生じます。このズレ具合を評価することで(特にバイアスとバリアンスを比べることで)未学習や過学習などを直感的に理解できるようになります。

予測性能

未学習とは

まず機械学習における未学習とは何かを説明します。

読んで字のごとく、学習が不十分なために、データを表現するモデルが全く得られていないような状態です。通常、訓練誤差が十分に減少していなければ未学習だと言えます。

これを解決するのはそれほど難しくなく、ハイパーパラメータを調整しながら、とにかく訓練誤差が下がるまで実験を繰り返せばいいです。基本的に、この訓練誤差をある程度下げられるようになってから、後の細かい調整を行っていきます。

過学習とは

学習済のモデルが過学習になっている場合は、未知の新たなるデータを入力した際の予測性能が著しく低いです。つまり訓練誤差を下げることに集中しすぎてしまい、与えた訓練データを「無理やり」表現するようなモデルになってしまった状態です。

機械学習の本来の目的は、未知のデータを予測することであり、その予測を行うために手元にあるデータからそれが可能なモデルを構築するのを「学習」と言いました。過学習は典型的な学習の失敗例です。

未学習だけの場合は解決は簡単ですが、これを克服しようと訓練データを学習させているうちに過学習に陥ってしまうケースが大半です。

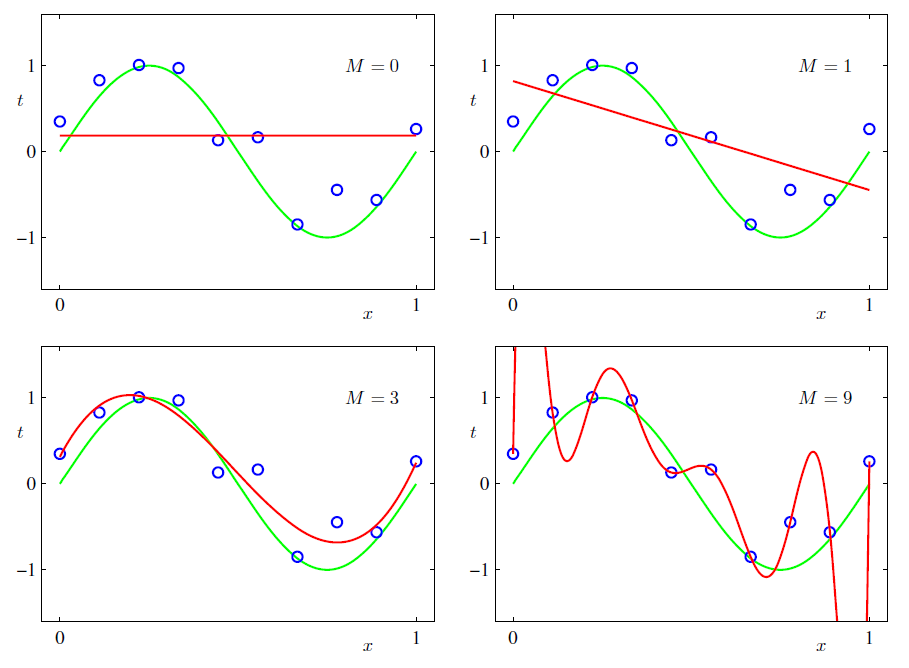

多項式フィッティングにおける未学習と過学習の例

例えばデータが関数から生起しているものとして、これがノイズの影響を受けて少しズレた点に生じるとしましょう。

下の図における青い点が、手元の実データです。

緑の線が真のモデル(関数)です。

コレに対して赤い線でフィッティングをしようという問題です。

のような多項式で青い点のデータをフィッティングする場合には、の値(つまり多項式の次数)が高いほど複雑な曲線を表現できます。フィッティングの結果が以下の画像です。

の場合は完全に未学習と言えます。青いデータ点をほとんど上手く表現できていません。

では、青い点(つまり手元のデータ)すべてを通過する曲線が得られており、訓練誤差だけで言えば非常に優秀です。しかし、この青い点は緑の曲線から生起したものであり、本来のデータの背景を捉えられているとは言えません。新たなデータ点が緑の曲線から生起した時には、そのデータ点を予測するのが困難だというのが分かるでしょう。これが過学習です。

大抵は、モデルを複雑にしさえすれば、訓練誤差を下げることができます。無理やり帳尻合わせができるからです。つまり未学習の解決は容易なのです。

一方で過学習の解決は通常かなり難しいです。まさかがちょうど良いなどということは、最初から知っているわけではありません。何度も学習をして、ちょうど良い値を見つけ出さなければならないのです。

正則化の効力

下記は正則化というものを用いた場合のフィッティングの様子です。

は正則化の強さを表す係数で、学習時に適当に設定します。

正則化を導入する場合には、多項式フィッティングでの次数の設定は「大きめに」取っておけばよく、過学習しそうな部分を正則化で抑制することができます。大抵

を調整するより正則化の強さ

を調整するほうが楽でしょう。

ニューラルネットなどのようにモデルが複雑であればあるほど、正則化に任せる方が考えるべきパラメータを少なくできます。

ここでは、正則化も未学習や過学習を調整するものであるということを納得しておいてください。

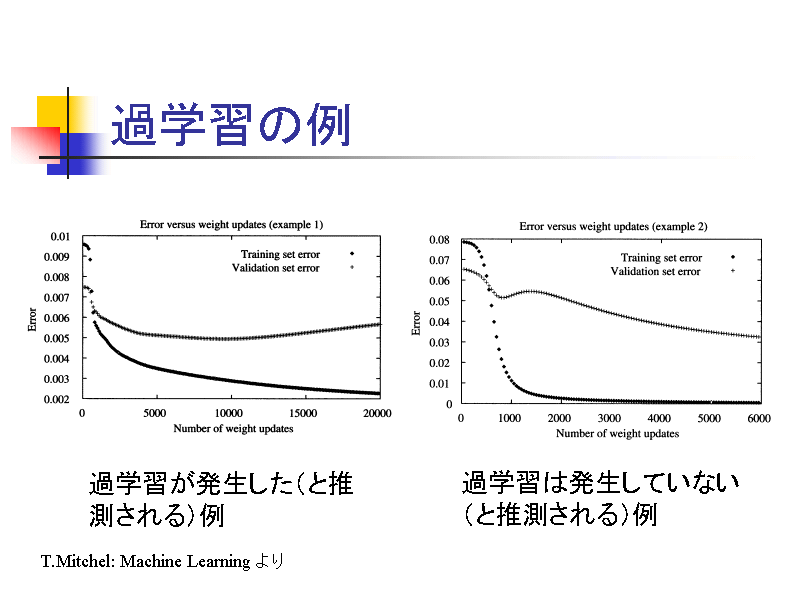

評価をするために

もしも学習をしている最中に過学習に陥っていることに気づけたならば、それ以上学習を進める意味はあまり無いでしょう。それを知るために、機械学習を行う際には訓練データでパラメータを更新するたびに、訓練に用いていないデータを予測するということを行います。

つまり、現段階において予測誤差がどれほどであるのかを逐一チェックするのです。

パラメータが更新されるたびに訓練誤差が下がっていく一方で、予測誤差悪くなっていくのであれば、それ以降は過学習していく傾向があると掴めるわけです。

ここで言う訓練誤差のことを通常は「training error」、予測誤差のことを「validation error」などと言います。大抵の機械学習のライブラリでもvalidationデータを使って、学習中に評価するような仕組みは備わっているはずです。(備わっていなくても作るのは簡単)

(櫻井研究室の講義資料より抜粋)

損失関数の期待値とその分解

バイアス-バリアンス分解は未学習や過学習の状況を理論的に解析する手法です。

これを考えていく上では、まず損失関数の期待値の分解というものを考えなければなりません。

知識的な前提として確率・統計での期待値操作や、テクニカルな面では積分変数の把握ができることが必要となります。

損失関数

訓練データに対する正解の値

がデータとして手元にあるとします。そしてこれからモデル

という関数によって、

と

の関係を学習させようという設定を考えます。

まず、モデルを学習させる際には損失関数[texL]が必要です。損失関数によって誤差を定義します。ここでは回帰の問題で一般的な二乗誤差を使います。

これによって、モデルが正解データ

からどれほどズレてしまっているのかを表現することができます。

がなるべく小さくなるように

を決定しようというのが学習です。

損失の期待値の最小化

と

というデータが得られる同時確率を

とします。

損失の期待値は以下です。

機械学習ではこれを最小化するのが目的です。ここで、確率分布の乗法定理によって

とすることができ、これによって積分を

と書き換えることができます。この積分が最小となるためには、括弧の中身(での積分)が最小化されねばならず、このとき機械学習では

を調整するので

を満たさなければなりません。一見難しそうですが、単にでひとまとまりの変数だと思って偏微分すればよく、

(は

を含まないので積分の外へ)

( (確率分布は積分したら

))

これがとなればよく

と求まります。これは回帰問題においてを条件付き期待値

で決めると最小化されるということです。

例えばという値に対して、データ

を集めた場合に、ノイズが生じて

になったり

になったりする場合は、きっと

に対して

くらいだろうと見積もることでしょう。

実際の機械学習では、たくさんのいろんなという入力に(例えば入力電圧)対して、得られる正解のデータ

(回路の出力電流)があり、その期待値によってモデル(電圧-電流の関係)を構築すると誤差が最小化できるということですが直感的にもそうだと言えますね。

損失の期待値の分解

ここで、理論的な解析を進めるために二乗損失関数の期待値を「具体的に積分計算せずに」、操作を施していきます。二乗損失関数は以下でした。

これの期待値

について解析していくということになります。

ここで、変形がテクニカルになるため、丁寧に見て行きましょう。

に対して、という恒等式を使います。

(引いて足したら、当たり前!)

この変形は当然いつでも成り立ちます。(を入れているだけだから)

更に、一見するとテクニカルに見える処理を見やすくするために、以下のように括弧を使って、あたかものようにみなせるように書き換えます。

この状態に対してのように計算を進めることで

と変形することができます。従って、

であり、この期待値は

ですが、実は期待値を取るとこの第二項に関してはとなります(期待値は

に関して積分ですが、第二項はそのときに消えます)。第二項に関して詳しく計算をすると下記のようになります。

従って、まとめてしまえば損失関数の期待値は

と表すことができます。

まとめ

損失関数は以下の最小自乗損失を用いる。

このとき、損失の期待値を最小化するモデルは以下の条件付き期待値となる。

損失の期待値は以下のような2項に分解することが可能である。

バイアス-バリアンス分解

訓練データというパラメータ

損失関数の期待値が

であることを見てきました。

ところが、訓練データの集合というのは有限です。つまり真のデータのほんの一部を借りてきているに過ぎません。そして、データ1つ1つ

を得てくる際には、真のデータからわずかにズレを生じていることでしょう。

そうなってくると当たり前のことですが、これから作るモデルというのは、全く同じ手法を使ったとしても、集めてくる訓練データの集合に依存することになります。

したがって、これを明示的に意識するために

と書くことにします。

また、損失関数を減少させるようにモデルをフィットさせる時には訓練データに対して行っているのであって、

というように、損失関数の期待値はに対して計算されることを明示します。

完全なるノイズ項

ここで、完全なるノイズ項を説明しておきます。

以下の式を、期待値計算を項ごとに行うとして

と分けることにします。このときの第二項にはノイズ項です。lこの項に機械学習で獲得するモデル

は含まれていません。

このノイズ項は、機械学習の手法でどれだけ頑張っても、改善することのできない項なのです。

つまり損失関数を低減する上では、この項に成すすべはないということになります。

機械学習で過学習も抑えて、なるべくうまく学習できたと思っても、テストデータの予測性能がどうしても訓練データに見劣りすることがあります。しかしそれは、ある意味仕方のないことでもあるのです。学習は手元に集めたデータのみを考慮しますし、汎用性能を高めようと過学習を抑えてたとしても、ノイズの項は残ってしまうためです。

機械学習では、この第一項の方を考えていくことになります。

バイアス-バリアンス分解

では第一項の方を見て行きましょう。

この式に対して、という恒等式を差し込みます(損失関数を分解したときに使ったのと同じテクニックです)。

続いてという計算をするために期待値[texE_D]の中身の項を2つにわけます。

期待値の中身を展開します。

これの第3項は期待値を計算すると

になるので、結局

と計算されることになります。この第一項をバリアンス、第二項をバイアスと言います。

全体としては、損失関数の期待値は

(バリアンス)

(バイアスの(二乗))

(ノイズ)

と分解されることになります(バイアス-バリアンス分解)。

バリアンス

機械学習によるモデルによる予測が、訓練データ集合によって変動する度合い(の期待値)を表しており、訓練データに依存し過ぎることで新しいデータへの予測が悪化する度合いを表しています。

言わば過学習に対する指標となります。

バイアス

機械学習によるモデルが、損失の期待値を最小化する

からずれる度合い(の期待値)を表しており、モデルが単純であるあまりに学習が上手くいかない度合いを表しています。

いわば未学習に対する指標となります。

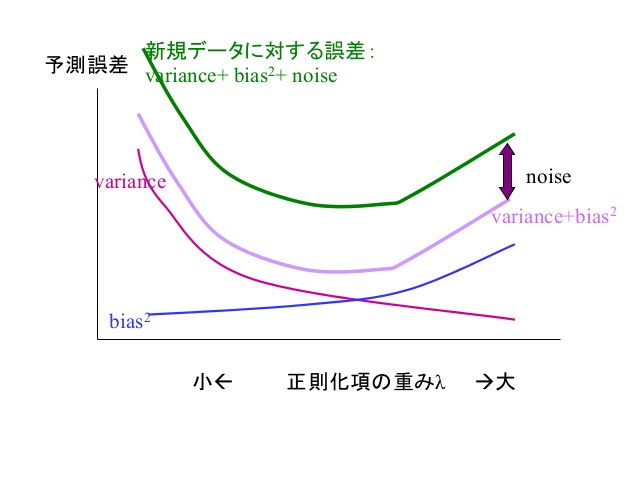

バイアスとバリアンスのトレードオフ

バイアスとバリアンスはトレードオフの関係にあります。

未学習と過学習の関係を考えれば当たり前ですが、これを定量的に評価できることに意味があると言えるでしょう。以下の図を見てください。正則化によって過学習制御を行った場合の、バリアンスのバイアスの関係です。

過学習制御を小さくしておけば、訓練データに対してはフィットするためバイアスは小さくなります。一方で、データに依存しすぎたあまりに生ずるバリアンスは大きくなります。

過学習制御を大きくすれば、訓練データへの依存度であるバリアンスは小さくなりますが、訓練データにすらフィッティングできなくなりバイアスが上昇します。

損失の期待値は、バリアンスとバイアス(とノイズ)の和であり、バイアスとバリアンスが両方共なるべく低い位置で正則化を決めることで、新規データに対する誤差も小さくなりうるということです。(バイアスとバリアンスの和と、新規データに対する誤差との差がノイズの項で現れる)

もちろん現実では、データがあまり信頼できないならば、バイアスが少々大きくともバリアンスの減少を優先するなどの方法も考えることができます。

全体のまとめ

損失関数の訓練データに対する値の期待値を減少させることが機械学習における学習である。その際、訓練データに最適なモデルは

で与えられる。

しかし、本来の目的は新しいデータへの予測であるため、上記のように完全に訓練データにフィットさせるということはしない(過学習を防ぐ)。

訓練データへのフィットと、新しいデータへの予測ということを考慮したときにバイアス-バリアンス分解というものを考えることができ、損失関数の(訓練データに対する)値の期待値は

(バリアンス)

(バイアスの(二乗))

(ノイズ)

で表される。

ノイズは機械学習では対応できない本質的に残留するもの。

バリアンスとバイアスはトレードオフであり、訓練データへのフィットと過学習抑制を同時に考慮する際に、モデルの評価として用いられる。

参考となる書籍

- 作者: C.M.ビショップ,元田浩,栗田多喜夫,樋口知之,松本裕治,村田昇

- 出版社/メーカー: 丸善出版

- 発売日: 2012/04/05

- メディア: 単行本(ソフトカバー)

- 購入: 6人 クリック: 33回

- この商品を含むブログ (18件) を見る